Nota: alcuni link presenti in questo articolo sono affiliati. Questo significa che potremmo guadagnare una piccola commissione se decidi di acquistare tramite uno di questi link, senza variazioni di prezzo per te.

L’intelligenza artificiale ha introdotto una nuova dimensione nella scoperta dei contenuti: il traffico non passa più solo dalle query tradizionali, ma sempre più spesso attraverso assistenti conversazionali e modelli linguistici come ChatGPT, Perplexity o Google AI Mode. In questa realtà in continuo mutamento, monitorare il traffico generato dall’IA non è tanto un’opzione, quanto una competenza strategica.

Perché bisogna monitorare il traffico proveniente dalle IA

Il modo in cui gli utenti scoprono un brand sta cambiando velocemente. Non basta più farsi trovare su Google: oggi la partita si gioca anche dentro le risposte generate dall’intelligenza artificiale, dagli assistenti come ChatGPT a motori conversazionali come Claude o Perplexity.

I numeri parlano chiaro: più del 70% dei consumatori americani utilizza già strumenti IA per cercare informazioni, e chi arriva sul sito dopo una ricerca mediata da un LLM è fino a quattro volte più propenso a compiere un’azione rispetto a chi proviene dalla ricerca organica tradizionale. È un traffico meno voluminoso, ma di qualità superiore, perché gli utenti arrivano più informati e pronti a interagire.

Naturalmente, questo scenario porta con sé anche nuove sfide. Non distinguere il traffico reale da quello generato dai bot IA significa ritrovarsi con dati distorti: sessioni gonfiate, tassi di rimbalzo incoerenti, conversioni poco affidabili. Per chi prende decisioni basate sulle metriche, è un rischio enorme. Segmentare e monitorare correttamente queste visite diventa quindi un passaggio obbligato per mantenere integra la qualità dei dati e orientare strategie di marketing più precise.

C’è poi un aspetto di prospettiva: secondo le previsioni, entro il 2027 i canali LLM genereranno un impatto economico paragonabile a quello della ricerca tradizionale, superandola poco dopo. Questo significa che chi oggi impara a leggere e interpretare i segnali provenienti dall’IA non solo difende le proprie performance, ma costruisce un vantaggio competitivo che si rafforzerà negli anni.

Monitorare il traffico dalle IA, in altre parole, non è una questione tecnica da addetti ai lavori: significa comprendere come il brand viene raccontato dai modelli conversazionali, distinguere le interazioni automatizzate da quelle umane e farsi trovare pronti davanti a un cambiamento che non è futuro, ma già presente.

Come cambia il traffico organico con l’avvento di AI Mode, Perplexity e ChatGPT

Con l’arrivo di piattaforme come ChatGPT, Perplexity o l’AI Mode di Google, il modo in cui le persone trovano le informazioni online non è più lo stesso. Il vecchio percorso lineare — query, risultati, clic — si sta sgretolando a favore di un ecosistema in cui l’intelligenza artificiale diventa l’intermediario principale tra domanda e risposta.

Uno degli effetti più evidenti è il calo del CTR dei risultati organici tradizionali. Quando l’utente trova la risposta direttamente nell’AI Overview, spesso non ha più motivo di cliccare. Negli Stati Uniti, dove queste funzionalità sono già diffuse, il calo di traffico è tangibile, e lo stesso scenario si prospetta per l’Europa nei prossimi mesi.

Ma il quadro non è solo negativo. Parallelamente nasce una nuova metrica di successo: l’AI visibility. Non si tratta più di scalare le SERP, ma di capire quante volte un brand viene citato o raccomandato nelle risposte degli assistenti IA. Considerando che oltre il 70% dei consumatori americani utilizza strumenti di intelligenza artificiale per le proprie ricerche, farsi trovare in questi spazi significa entrare in contatto con utenti in momenti decisivi del loro percorso informativo.

Nonostante i volumi di traffico generati da tool come Perplexity o Gemini siano ancora contenuti, i dati mostrano una qualità nettamente superiore. Gli utenti arrivati tramite IA convertono fino a quattro volte di più rispetto a quelli provenienti dalla ricerca organica classica, e in alcuni casi oltre il 60% compie un’azione sul sito. È la dimostrazione che chi arriva da queste piattaforme non cerca solo informazioni generiche, ma arriva già “educato” e più vicino alla conversione.

C’è però un rovescio della medaglia. Non tutto il traffico che appare come proveniente da IA è realmente umano. Gli assistenti spesso precaricano contenuti o simulano interazioni che possono gonfiare visualizzazioni e sessioni, falsando metriche cruciali come il bounce rate o il tempo medio sulla pagina. Se non vengono segmentati correttamente, questi dati rischiano di compromettere le analisi e portare a decisioni sbagliate di marketing.

Un altro aspetto da non sottovalutare riguarda il comportamento di citazione degli LLM. Perplexity tende ad attingere dai primi dieci risultati di Google, Google AI Mode segue logiche più autonome, mentre ChatGPT si discosta ancora di più dai risultati tradizionali. A dominare le citazioni sono spesso piattaforme come Reddit e YouTube, mentre i brand “istituzionali” rischiano di passare in secondo piano se non producono contenuti granulari e specifici.

In questo nuovo contesto, monitorare il traffico IA non è un optional. È l’unico modo per distinguere le interazioni reali da quelle automatizzate, preservare l’integrità dei dati e, soprattutto, ripensare la propria strategia SEO e di contenuti in un panorama dove l’intelligenza artificiale non è più un contorno, ma un punto di passaggio obbligato.

Il tuo sito perde traffico a causa delle IA? Come capirlo

L’intelligenza artificiale ha cambiato le regole del gioco. Non si limita più ad accompagnare le ricerche, ma ne ridisegna le dinamiche, si posiziona come intermediario tra l’utente e i contenuti online. Assistenti conversazionali e modelli linguistici come ChatGPT, Claude, Perplexity o Gemini intercettano le intenzioni prima che l’utente clicchi su un risultato, con un impatto diretto sul traffico dei siti web.

Il segnale più chiaro di questa trasformazione è il calo del CTR nei risultati organici. Le AI Overview di Google mostrano risposte immediate dentro la SERP, da cui un calo drastico dei click: meno traffico dai motori di ricerca tradizionali, più “visibilità mediata” dall’IA.

Capire se un sito è coinvolto da questo cambiamento richiede uno sguardo più profondo alle metriche. In Google Analytics 4, ad esempio, possono comparire fonti di traffico insolite come chat.openai.com, perplexity.ai o gemini.google.com, spesso tracciate come traffico diretto o referral generico. Allo stesso tempo è possibile notare sessioni dalla durata irrealistica, che si chiudono in pochi secondi senza interazioni o, al contrario, rimangono aperte a lungo senza alcuna azione. Bounce rate anomali, caricamenti istantanei delle pagine e user agent sospetti sono altri segnali che tradiscono la presenza di interazioni automatizzate. Tutti questi indizi, se non interpretati correttamente, rischiano di alterare la percezione della performance e di influenzare negativamente le decisioni strategiche.

Per rendere più leggibile questo fenomeno si può intervenire direttamente nelle impostazioni di GA4. Creare un’esplorazione personalizzata, usando “Page Referrer” come dimensione principale e filtrando con espressioni regolari i domini riconducibili ai chatbot più diffusi, permette di separare le visite umane da quelle generate dall’IA. Una soluzione ancora più efficace è la creazione di un gruppo di canali dedicato al traffico IA, così da integrarlo nei report abituali e metterlo sullo stesso piano degli altri canali di acquisizione. Questo non solo facilita i confronti, ma offre ai decision maker un quadro più chiaro del reale impatto delle interazioni mediate dall’intelligenza artificiale.

Isolare il traffico IA è solo il primo passo. Il vero valore sta nell’interpretazione. Gli studi dimostrano che chi arriva da una risposta AI ha una propensione alla conversione molto più alta rispetto agli utenti provenienti dalla ricerca organica tradizionale. In alcuni casi il tasso di azione sul sito arriva al 63 per cento, contro una media del 20 per cento degli altri canali. Questo non significa che basti farsi citare per ottenere risultati, ma che quelle citazioni vanno rese più efficaci con metadati curati, titoli persuasivi e call-to-action capaci di trasformare una menzione in un accesso reale al sito.

Per i marketer questo significa che le metriche di ranking tradizionali non bastano più. La vera sfida è capire come e dove l’IA cita il brand e usare quelle menzioni come leva per generare interazioni autentiche. Solo così il traffico mediato dall’intelligenza artificiale smette di essere una variabile incontrollabile e diventa una nuova opportunità di crescita.

Quali sono le differenze tra il traffico dei chatbot e dei visitatori umani

La distinzione tra il traffico generato dai chatbot e quello degli utenti reali è ormai un tema centrale nell’analisi digitale. Da un lato ci sono i visitatori umani, che arrivano su un sito con un obiettivo chiaro e un percorso di navigazione logico; dall’altro ci sono i bot AI, che producono accessi automatizzati e comportamenti molto diversi dalle interazioni genuine.

La prima conseguenza di questa differenza riguarda l’integrità dei dati. Le visite dei bot tendono a gonfiare le visualizzazioni di pagina e a distorcere le metriche principali. È così che ci si ritrova con tassi di rimbalzo poco realistici, sessioni che sembrano più lunghe o più brevi di quanto dovrebbero, e valori di conversione che non rispecchiano il comportamento reale dei clienti. Spesso i LLM precaricano interi contenuti per conto dell’utente, generando richieste al server che finiscono tracciate come “traffico diretto” o referral senza una fonte chiara.

Molti operano in ambienti cloud headless, con risoluzioni statiche e senza cookie persistenti. Alcuni faticano con il rendering grafico complesso, altri mostrano pipeline audio inesistenti o accedono ripetutamente alle stesse pagine a intervalli regolari. In più, i loro header User Agent spesso contengono identificatori unici che li distinguono da un browser tradizionale.

Come monitorare il traffico dei chatbot in GA4

Monitorare il traffico generato da chatbot e modelli linguistici in Google Analytics 4 è una delle nuove sfide del marketing digitale. GA4, infatti, non offre un metodo nativo per distinguere queste visite, che finiscono per gonfiare visualizzazioni di pagina e rendere poco affidabili metriche chiave come bounce rate, durata della sessione e conversioni. La distinzione non è un dettaglio tecnico: significa preservare l’integrità dei dati e, di conseguenza, la capacità di prendere decisioni informate.

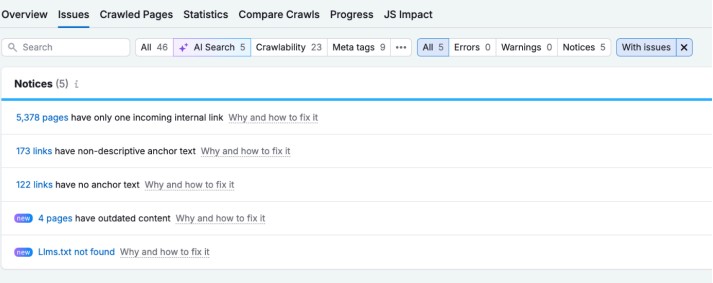

Un primo approccio consiste nell’usare le Esplorazioni personalizzate.

Creando una nuova analisi con “Page Referrer” come dimensione e “Sessions” come metrica chiave, diventa possibile isolare i domini più ricorrenti tra i chatbot. Con l’aggiunta di filtri regex, le visite provenienti dall’IA emergono chiaramente, rendendo evidente quanto incidono sul totale. Se a questo si affianca un gruppo di canali dedicato al “Traffico AI”, i report standard iniziano a mostrare il fenomeno in modo ordinato e confrontabile con gli altri canali di acquisizione.

Accanto alle configurazioni di GA4, c’è la possibilità di lavorare in modo più raffinato con Google Tag Manager. Qui si possono impostare variabili personalizzate che intercettano referrer e user agent tipici dei bot, e far scattare trigger dedicati che inviano a GA4 eventi come “ai_bot_traffic_detected”.

In questo modo, il traffico generato dall’intelligenza artificiale può essere registrato, segmentato o escluso dai report, a seconda delle esigenze. GTM consente anche di tracciare casi particolari come i Text Fragments (#:~:text=) usati da Google nelle AI Overview per evidenziare passaggi specifici: intercettando questi parametri, si ottengono dati preziosi su come i contenuti vengono mostrati e utilizzati dall’IA.

Un ulteriore livello di precisione si raggiunge quando i link suggeriti dai chatbot contengono parametri personalizzati, per esempio “?fonte_ai=chatbotGPT4”. In GA4 è sufficiente registrare questo parametro come dimensione personalizzata per ricostruire il percorso di conversione degli utenti arrivati grazie all’IA, anche quando tornano al sito in sessioni successive.

L’aspetto decisivo non è tanto la tecnica, quanto il modo in cui questi dati vengono letti. Se l’obiettivo di un’azienda è misurare brand awareness e content marketing, monitorare il traffico AI diventa un’opportunità: sapere quante volte e in quali contesti un brand viene citato permette di capire il proprio posizionamento nell’ecosistema dei modelli linguistici. Se invece la priorità è il calcolo puntuale del ROI pubblicitario, allora può essere più utile filtrare ed escludere queste visite, per non ritrovarsi con metriche gonfiate e performance distorte.

Come Semrush ci aiuta a monitorare il traffico delle IA

La ricerca online non si esaurisce più nelle SERP tradizionali. Oggi la vera sfida per i brand è capire quanto spesso e in che modo vengono citati dalle intelligenze artificiali. La cosiddetta “AI visibility” non misura un ranking, ma la presenza del marchio nelle risposte generate da ChatGPT, Claude, Perplexity o dalle Google AI Overviews.

Semrush è tra i primi ad aver introdotto strumenti dedicati a questo nuovo scenario. Il Semrush AI SEO Toolkit permette di analizzare come i chatbot citano il brand e i competitor, oltre a mostrare non solo la frequenza delle menzioni, ma anche il sentiment che l’IA associa a ciascun marchio. Un altro aspetto prezioso è la possibilità di identificare le query non-branded che portano a menzioni del brand, cioè le domande generiche degli utenti in cui l’IA include spontaneamente il marchio nella risposta. In questo modo non si monitora soltanto la presenza, ma anche il contesto in cui il brand viene percepito e raccomandato, con raccomandazioni pratiche per ampliare la propria visibilità AI.

Per le aziende che operano su scala più ampia, il Semrush Enterprise AIO porta questa logica a un livello superiore. Oltre a monitorare l’andamento della visibilità AI nel tempo, offre una misura dello share of voice rispetto ai concorrenti, ossia la quota di presenza del brand nelle risposte AI. Consente di approfondire le fonti a cui gli LLM attingono, distinguendo se le citazioni arrivano da contenuti corporate, blog specialistici, community come Reddit o canali come YouTube. Questo aspetto è fondamentale, perché suggerisce con precisione dove intervenire per rafforzare la propria autorevolezza.

La piattaforma permette anche di generare prompt specifici, mappando la visibilità del brand lungo l’intero percorso di acquisto dell’utente. Si ottengono così insight su come l’IA rappresenta concetti, prodotti e sentiment legati al marchio, con un dettaglio che altrimenti richiederebbe ore di test manuali su singole piattaforme.

Semrush trasforma un lavoro che manualmente sarebbe lento e frammentario in un flusso di dati aggregati e strategici. Per i marketer significa poter trattare la visibilità AI come una vera e propria KPI, misurabile e ottimizzabile al pari di ranking e traffico organico. In un contesto dove l’IA sta ridefinendo il modo in cui gli utenti scoprono i brand, avere strumenti di questo tipo significa non limitarsi a osservare il cambiamento, ma governarlo e trasformarlo in un vantaggio competitivo.

Come abbiamo visto, il monitoraggio del traffico dalle IA non è solo questione di numeri: è la chiave per trasformare visibilità mediata in valore reale—e per mettere il tuo brand un passo avanti nel futuro della ricerca. Attiva ora il toolkit AI SEO!